“I limiti del mio linguaggio significano i limiti del mio mondo”.

(L. Wittgenstein)

Quando Jacques Lacan propose la sua teoria psicoanalitica basata sull’influenza del linguaggio sugli esseri umani, molti uditori rimasero inizialmente stupiti. Il linguaggio è una limitazione effettiva? Nella cultura popolare, non è così. Non può essere! Ma, in un mondo in cui continuiamo a lavorare con rappresentazioni interne, è molto più di una limitazione: è una gabbia dorata senza via d’uscita.

Prima di tutto, una rappresentazione interna ha bisogno di un ambiente esterno e, in alcune condizioni, deve anche essere condivisa da un numero concreto di persone. Una giungla, come qualsiasi altro luogo naturale, è un punto di partenza perfetto. Tuttavia, una rappresentazione interna è più di un segnaposto. Pensare in questo modo porta a errori drammatici. La parola “albero” non è un albero vero e proprio e non lo sarà mai, ma la parola “albero” è un’entità che trasforma un elemento ambientale in qualcos’altro. Chiamiamolo, però. Non importa. L’unica cosa importante è che tale nuova entità sia un mattone per una linea di ragionamento intelligente.

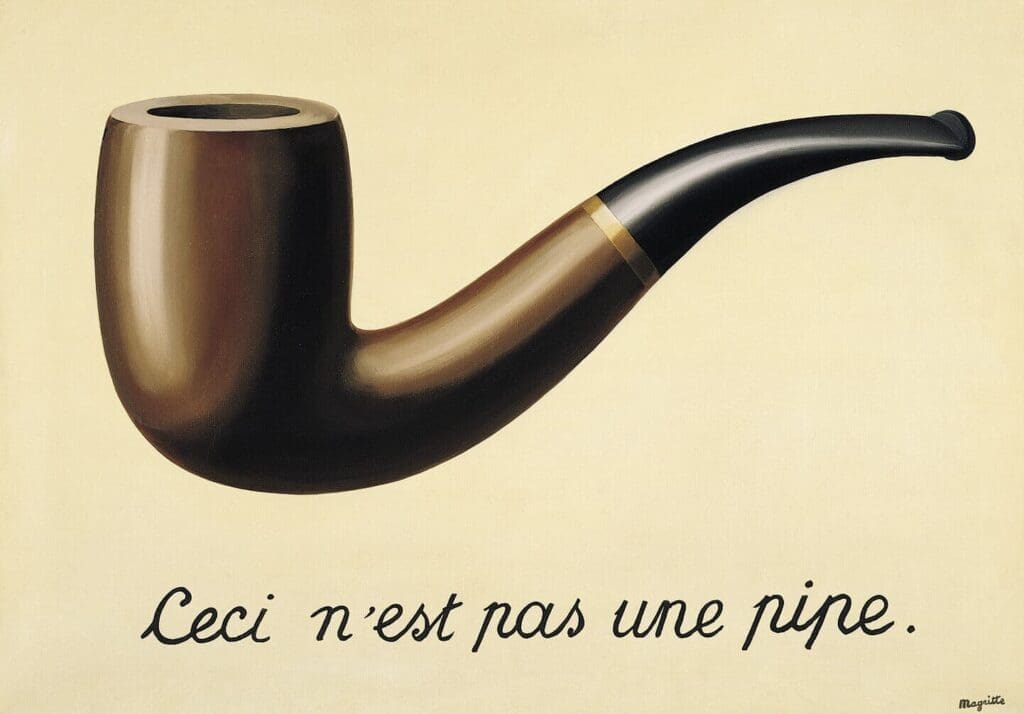

Consideriamo un altro esempio: “Il tradimento delle immagini”, dipinto da René Magritte. Naturalmente, il quadro non è un tubo, ma da un certo punto di vista, lo è! È un ‘tubo’ perché può innescare una catena rappresentativa interna. Una linea che può partire dal colore del legno e finire nel volto di un tabaccaio che vende pipe simili. Tubi simili? Vende quadri o poster? No… Certo. Questo è il link rappresentativo! Nella nostra mente, quel “tubo” è potenzialmente qualsiasi tubo (con qualsiasi forma, colore, materiale e così via); quindi, è molto più di un oggetto singolare. Il linguaggio lo ha trasformato in una rappresentazione astratta quasi onnipotente.

Ora, sorge la prima domanda: “E l’Intelligenza Artificiale?” Possiamo sicuramente affermare che tutti questi concetti hanno a che fare con l’intelligenza e, con uno sforzo minimo, è possibile trovare centinaia di documenti i cui obiettivi sono legati all’idea di modellare entità rappresentative astratte e manipolarle in compiti complessi. Un Chatbot è un chiaro esempio di questo approccio. Naturalmente, non sto parlando di bot specifici per un dominio (che sono FAQ un po’ più flessibili), ma di tutti quei tentativi di creare un programma con cui chattare. Un programma in grado di rispondere a domande come: “Come sta?” (forse potrebbe essere più interessante una domanda come “Qual è il Vbe del suo 345365esimo transistor?”) o “Le è piaciuto il suo ultimo viaggio?”. (Dove? Esiste un “dove” per il chatbot?).

Un paio di mesi fa, gli esperimenti di Facebook non sono riusciti a riprodurre una buona interazione verbale inglese (un linguaggio in cui l’astrazione dei numeri regredisce nella ripetizione della stessa parola segnaposto… “Io do uno uno uno cose…. Lei ha due carte), un’enorme massa di persone (intelligenti, però) ha iniziato a twittare e a postare: “Un’intelligenza artificiale ha creato il suo – forse sarebbe meglio ‘suo’ – linguaggio” e migliaia di commenti sono apparsi come funghi dopo una tempesta.

Non si sorprenda: un’intelligenza artificiale ha creato il proprio linguaggio. È vero. Se si addestra un modello Word2Vec, l’incorporazione interna delle parole è una rappresentazione artificiale che un essere umano non può comprendere (quando il numero di dimensioni è superiore a 3). Ma che dire del contesto? L’ambiente è assolutamente assente. Il motivo è semplice: questi modelli sono addestrati con dati generati dall’uomo e imparano a mappare (si pensi a un modello Seq2Seq ) un ingresso a un’uscita. (Per sfortuna), questo processo aveva bisogno di uno sfondo: Magritte aveva bisogno di una pipa vera (forse diversa, ma probabilmente un oggetto da cui fumare), e i primi abitanti delle caverne avevano bisogno di alberi e animali veri prima di dipingere le scene di caccia sulle rocce. Una mappa basata su relazioni esterne (definite da qualche agente misterioso) può spiegare il condizionamento pavloviano, ma non può giustificare come il linguaggio possa co-creare la realtà.

Non sono pessimista. Credo nella scienza e nella tecnologia. Ma, allo stesso tempo, odio il marketing! Anche quando si tratta di AI marketing. Vogliamo davvero studiare come l’intelligenza artificiale possa sviluppare un linguaggio? Per prima cosa, definiamo l’ambiente. Un robot in grado di esplorare un parco ha molte più possibilità di un programma addestrato con un enorme set di frasi. Di nuovo, il punto è l’obiettivo: ci aspettiamo che il robot esplori perché ne abbiamo bisogno? Se è così, può emergere un proto-linguaggio come necessario (i segnali di rinforzo possono essere codificati e memorizzati in qualche modo). Ha una struttura semantica? Sì, se non pretendiamo di “esportare” la nostra semantica. No, se continuiamo a chiedere al robot: “Ti piace l’erba?”. (La situazione può peggiorare quando qualcuno pensa di trovare un amico AI con cui chiacchierare).

Inoltre, dimentichiamo l’inglese o l’esperanto. Una lingua deve emergere con le proprie regole, il proprio alfabeto e forse con le proprie “sfumature”. Una traduzione (se tali robot sono davvero interessati…) può essere un lavoro successivo. Cercare di anticiparlo, anche se siamo un popolo conquistatore, può solo portarci a “cloni vuoti”, che sono ancora peggio degli automi cellulari (che sono meravigliose espressioni matematiche).

Ricordo sempre e ripeto il dialogo tra Alan Turing e il poliziotto in “The Imitation Game”. L’ufficiale chiese: “Una macchina può pensare?” e lui rispose: “Sì, può. Ma a modo suo”.

Se ti piace l’articolo, puoi sempre fare una donazione per supportare la mia attività. Basta un caffè!