I pro e i contro del Test di Turing

Un test comportamentistico quindi, il cui fine non era quello di identificare se e dove ci potesse essere intelligenza, ma piuttosto di valutare il grado di abilità del sistema artificiale nel dare risposte consone e spiazzanti; naturalmente quando si parla di macchina in questo ambito, è sempre importante precisare che non viene mai fatta menzione dei requisiti hardware necessari per poter conseguire un certo risultato. Lo stesso Turing basava le sue affermazioni più sulla lungimiranza che sulla consapevolezza e in [1] a pag.64 egli scrive: « …Io credo che tra una cinquantina d’anni sarà possibile programmare calcolatori aventi capacità di memoria di circa 109, in modo da farli giocare così bene al gioco dell’imitazione che un interrogante medio avrà una probabilità non superiore al 70% di compiere l’identificazione giusta dopo cinque minuti di interrogatorio. ».

La ragione di questa richiesta abbastanza alta (nell’ordine del gigabyte) di memoria è da ricercarsi proprio nell’approccio computazionale che Turing desiderava seguire: ciò che interessava realmente non era la struttura esteriore e le eventuali funzionalità grezze, ma piuttosto il programma, ovvero ciò che noi, controbattendo le affermazioni di John Searle, definiamo intenzionalità della macchina. Un dispositivo in grado di superare il test di Turing (ingannando quindi anche il più smaliziato degli interroganti) non è altro che un programma, più o meno variegato, che deve essere in grado di operare opportuni collegamenti tra le domande e le risposte, ma attenzione !

Io non ho detto che esso deve poter attuare solo ed esclusivamente un processo associativo ponderato, ma che il suo relazionamento con l’interlocutore deve necessariamente avvenire sulla base di un dialogo. Come vedremo in seguito questo approccio è già di per sé a netto sfavore della macchina ed è la causa dell’acceso dibattito che culminerà nell’esperimento virtuale della stanza cinese proposto da Searle. Io credo che Turing, nel formulare il suo gioco dell’imitazione, non intendesse esasperare il concetto di programma sino a spingere moltissimi ricercatori a creare due fazioni distinte (quella dell’IA forte e la sua opposta) ed è ben chiaro che molte ricerche contemporanee all’uscita del suo scritto “Computing Machinery and Intelligence” erano ancora in fase embrionale.

La macchina a stati finiti e il calcolatore digitale rappresentavano per i molti un traguardo di straordinaria inventiva umana e furono non pochi i registi che precorsero i tempi e animarono grossi ammassi di ferraglia sino a farli apparire a tutti gli effetti umanoidi; tuttavia oggi la situazione è cambiata radicalmente e molti entusiasmi hanno lasciato il posto ad una più cauta analisi dei dati di fatto.

Ed è proprio da ciò che intendo iniziare il mio discorso. Il test di Turing è, come abbiamo visto, comportamentista, ma è anche senza dubbio molto soggettivo poiché è proprio l’interrogante il giudice supremo che deve decidere se ha di fronte un uomo o una macchina, ovvero egli dovrà confrontare il comportamento (in termini di risposte) dell’interlocutore con quello di un’ipotetica persona di media cultura e capacità. Ma come è possibile avere sempre la certezza che un certo dialogo non può essere umano, mentre un’altro lo è ? Inoltre nel test è prevista la possibilità del bluff che, se sapientemente utilizzata, può gettare alle ortiche ogni barlume di determinismo nella decisione; ad esempio se doveste leggere questo dialogo:

-

- A) Come ti chiami ?

- B) xT334GhhdrN&353

- A) Sei una macchina ?

- B) 2rer%6gghd

- A) Cosa ne pensi dell’ingegneria genetica ?

- B) R&fffdwe55333

….

sareste in grado di dire chi è l’uomo e chi la macchina ? Di primo acchito tutti risponderebbero che B non soltanto non è umano ma è anche programmato molto male ! Ma ne siete certi ?

E’ possibile che A sia un programma che effettua delle domande e B sia un burlone che si diverte a confondere le idee… Il bluff è capace di sovvertire molte certezze e, per questa ragione, bisogna essere estremamente cauti quando si effettuano valutazioni “alla cieca”.

Chiaramente tutto sarebbe diverso se i due interlocutori fossero disposti l’uno di fronte all’altro e non ci fossero sistemi di telecomunicazione per pilotare la macchina da remoto. In questo caso quasi ogni dubbio verrebbe dissipato. Ho detto “quasi” perché nulla vieta alla macchina di scherzare ! Alla domanda qual è la tua fonte di energia essa potrebbe benissimo rispondere “i grassi e gli zuccheri”, oppure, in un caso estremo, essa potrebbe fare apparire sullo schermo una scritta “Errore di Sistema. Buffer Overflow”, al che ogni interrogante con poca pazienza sarebbe in diritto di alzarsi e ridere in faccia agli ingegneri… Il test di Turing, nella sua semplice genialità, prevede anche questo !

Tuttavia il contatto diretto con la macchina, qualunque essa sia, è sempre fonte di sgradevoli pregiudizi che lo stesso Alan Turing fa notare: « …Nel corso della propria vita un uomo vede migliaia di macchine e, da ciò che di esse vede, trae un gran numero di conclusioni generali: sono brutte, sono progettate ciascuna per uno scopo ben preciso e quando le si vuole usare per uno scopo anche solo un po’ diverso diventano inutili; la varietà di comportamento di ognuna di esse è limitata, ecc., ecc. …».

L’induzione psicologica che ci porta ad estendere le caratteristiche di un esemplare all’intera specie è sempre stata molto forte ma in questo settore il radicamento di idee pseudo-dualistiche ha spesso avuto la meglio su coloro che non riescono a raggiungere una posizione ferma. Molti biologi e filosofi si sono giustamente chiesti: E’ vero che il superamento del test di Turing conferisce intelligenza alla macchina ? Per chi volesse approfondire criticamente questo aspetto consiglio la lettura del capitolo “Il Test di Turing: una conversazione al caffè” di D. Hofstadter a pag. 76 di [1] , ma per adesso limitiamoci ad osservare, come già fatto in precedenza, che il gioco dell’imitazione è a netto sfavore per la macchina: essa è infatti costretta a rispondere ad una serie di domande poste in un linguaggio astratto e senza alcuna corrispondenza semantica; d’altronde, come scrive Daniel Dennet, « …l’assunto che Turing era pronto a sostenere era che nulla potrebbe mai superare il test di Turing vincendo il Gioco dell’Imitazione senza essere anche capace di compiere un numero indefinito di altre azioni manifestamente intelligenti… ».

Pensate di chiedere ad un computer cosa ne pensa delle mele, tutt’al più l’unica risposta accettabile potrebbe essere:

« La mela è un frutto gradito agli esseri umani e quindi anche a me ! », ma l’idea di mela posseduta dall’interrogante è certamente diversa dallo stato mentale (se presente) della macchina e quindi molte inferenze semantiche resterebbero vani tentativi di far quadrare i conti con la sintassi e, al massimo, un’ulteriore opportunità per convincere l’astante che essa (la macchina) è in realtà un uomo.

Ma la macchina non è un uomo ! Infatti se è sempre possibile accettare il contrario non bisogna però confondere un concetto particolare (l’uomo) con una categoria ben più vasta; un buon computer è una macchina e nessuna legge della fisica impedisce ad essa di comportarsi in modo intelligente, di sviluppare un pensiero autonomo, di interagire con il mondo (di cui fa giustamente parte) , ma nel contempo non esiste alcuna ragione per supporre che la sua intelligenza debba necessariamente conformarsi comportamental-mente (e soprattutto strutturalmente) con la nostra. La macchina potrebbe rifiutare il dialogo se il linguaggio non è quello corretto e sarebbe del tutto inutile tentare di estrarre informazioni da essa senza prima averne accettato una qualche sorta di autonomia esistenziale.

Più avanti avremo modo di discutere ampiamente sugli stati interni di un sistema artificiale, ma in questo momento mi preme sottolineare che, a mio parere, è troppo facile cadere vittima di belle illusioni ogniqualvolta che ci si trova dinanzi ad un grosso computer che sforna risposte pre-immagazzinate…

E’ ovvio che non c’è nulla di intelligente in tutto ciò, nemmeno se le inferenze che selezionano le alternative avvengono nella maniera più logica e rigorosa, e il semplice motivo è che la macchina “sa” di dover rispondere B alla domanda A solo perché un programma prescrive così, ma non ha idee né del programma né tantomeno dei sotterfugi da adottare qualora desiderasse aggirare gli inesorabili dettami algoritmici.

Una siffatta macchina è condannata ad essere un ottimo esempio di software per l’immagazzinamento e la gestione di dati, nulla di più. Io credo quindi che l’iniziale interrogativo di Turing, “Può una macchina pensare ?” non abbia trovato un reale esempio in quegli ipotetici sistemi in grado di sostenere il gioco dell’imitazione: un computer non dovrebbe imitare nulla, al massimo egli potrebbe comportarsi come un bravo interprete bilingue che parla ad un auditorio in Italiano, ma che continua a pensare nella sua lingua madre. Sono infatti le immagini mentali gli elementi che caratterizzano intrinsecamente il pensiero e la drastica decisione di sopprimerle del tutto creando un sistema puramente associativo equivale a distruggere qualsiasi possibilità che l’intelligenza artificiale possa realmente fare dei progressi.

Gli stati interni forniscono una rappresentazione dello status quo della macchina in un punto dello spazio-tempo ben preciso e la risposta ad una domanda è necessariamente influenzata da esso; come accade negli esseri umani, il sistema artificiale potrebbe essere distratto, svogliato, concentrato su ben altre faccende, e tutto ciò perché la sua attività interna è quasi del tutto indipendente dalle stimolazioni forzate che un tedioso interrogante può continuare a fare. Tuttavia, come lo stesso Dennet fa notare in [1], « …un altro problema sollevato ma non risolto nel dialogo di Hofstadter riguarda la rappresentazione. Quando si simula qualcosa al calcolatore, si ottiene normalmente una rappresentazione dettagliata, “automatizzata” e multidimensionale di quella cosa, ma naturalmente c’è una differenza abissale tra la rappresentazione e la realtà, non è vero ?… ». Certo !

La differenza c’è e ci deve essere, soprattutto quando si trattano macchine intelligenti. Se si scrive un buon programma per la simulazione delle eruzioni vulcaniche, lo si fa per valutare aspetti della realtà che qualora dovessero verificarsi porterebbero a catastrofiche conseguenze, ma il nostro caso è molto differente.

Noi non vogliamo simulare alcunché, né ciò che viene definito comunemente “mente umana”, né tantomeno quel tipo di intelligenza che gli scolari ogni giorno si sforzano di sviluppare. Voglio ribadire che una macchina, per buona pace dell’anima di Turing, può partecipare al gioco dell’imitazione, ma ciò non significa che essa è destinata a dover vivere all’ombra di chissà quale entità suprema di cui è solo un pallido riflesso.

Le previsioni meteorologiche trattano di continuo i sistemi multivariabile gestiti dalle equazioni di Navier-Stokes, ma giustamente, come evidenziato da Hofstadter, non è mai accaduto che un ammasso nuvoloso abbia scatenato un temporale all’interno di un laboratorio… Quelle sono simulazioni, ovvero imitazioni scientificamente calibrate; il loro fine ultimo è quello di assecondare le leggi della fisica in situazioni particolari. Una macchina intelligente, al contrario, non simula nulla poiché se una sua variabile interna assume il valore 5, essa ha realmente il valore 5 e tale numero non esiste al di fuori di quella specifica realtà poiché esso è a pieno diritto uno stato mentale; se invece io gestisco un software per la simulazione del volo, l’altitudine che leggo sullo schermo, pur essendo anch’essa una variabile, è esistenzialmente priva di qualsiasi significato. Sono io, con la mia interpretazione, a comprendere che quel segnale mi avverte di qualcosa e senza la dovuta consapevolezza esso può rimanere un semplice numero stampato su uno schermo.

Per questa ragione è importantissimo sottolineare che non esistono simulatori di intelligenza ! L’intelligenza è una proprietà autonoma che, nel momento in cui si cerca di replicarla, svanisce come una bolla sospinta da un soffio…

Essa emerge certamente da un’architettura funzionale, ma non esiste alcun metodo razionale (solipsismo) per essere certi che un certo organismo pensa e ragiona come sto facendo io in questo momento, l’unica via di fuga nasce da un’accorta applicazione del principio di induzione che, in questo caso, afferma che un individuo capace di sostenere un dialogo per un certo tempo non può essere uno stupido !

Su queste basi nasce e si sviluppa il test di Turing, prova che, come abbiamo avuto modo di accertare, deve necessariamente “svelare” – qualora ci sia – l’esistenza di stati mentali interni attraverso la scoperta di comportamenti che, solo per ragione pratica, si avvicinano a quelli di un essere umano. Comunque non desidero che il termine “stato mentale”, nell’ottica di una ridicola “simulazione della psiche” venga barbaramente tradotto in emozione o sentimento…

Nel prossimo paragrafo affronteremo ampiamente questo problema, ma per adesso è bene fare una doverosa precisazione: anche se ricercatori come Goleman hanno più volte ribadito la necessità di considerare un’intelligenza detta appunto emotiva, ciò non vuol dire che l’equazione pensiero = emozione abbia un qualche senso logico. Le emozioni appartengono all’interpretazione mentale degli stati interni e lì devono restare, tirarle in ballo ogni volta che uno scienziato parla di IA è solo un modo per tentare di boicottare un lavoro che si basa su realtà di fatto.

Che senso hanno le frasi del tipo “Quella macchina non può amare…” ? Evidentemente la macchina non deve amare, perlomeno nel senso che noi esseri umani attribuiamo al termine, ma questo non inficia l’eventuale intelligenza che essa potrebbe avere (magari avrà uno stato interno particolare che per essa equivale ad una sorta di amore !); commisurare due realtà fisicamente e funzionalmente diverse è pericoloso e fuorviante e l’unico risultato che si ottiene è semmai una maggiore confusione e l’assodamento del pregiudizio che le macchine, come diceva Turing, sono brutte, stupide e poco flessibili.

Una macchina che prova emozioni

Sulla mia scrivania sono accatastate decine di articoli che riguardano l’IA, la psicologia e le scienze cognitive. Non ci credereste, ma in ognuno di essi trovare un breve riferimento alle emozioni è talmente certo che ci potrei scommettere l’intera mia libreria (la cosa più cara che posseggo)… Nel nostro caso il discorso può essere riassunto e schematizzato nella domanda: le macchine possono provare emozioni ?

Cominciamo dall’inizio e, da bravi logici, cerchiamo di capire che cosa sono queste odiate emozioni: supponiamo che una persona entri nel suo appartamento e, dopo qualche passo, si accorga che un’ombra si sta muovendo dietro un grande mobile, cosa accade a livello fisiologico in quell’individuo ? La risposta è semplice: compare quella che tutti noi abbiamo ormai battezzato come paura. Ma che cos’è la paura ? Il neuroscienziato Joseph LeDoux studia ogni giorno questo importantissimo processo, ma sono certo che se gli si chiedesse una definizione verbale (e semplice) del concetto di terrore egli si bloccherebbe come d’altronde farebbe chiunque.

In fondo ciò che noi chiamiamo emozione è solo un particolare stato mentale che si sovrappone alla configurazione corrente alterandone alcune caratteristiche, con lo scopo di preparare l’organismo ad attuare una ben precisa procedura. Ad esempio, se si ascolta la parola “Attento” esistono svariate reazioni organiche ed alcune di esse sono associate a forti emozioni – se si pone un punto esclamativo dopo il termine, già linguisticamente il significato cambia, e se a pronunciarlo è una persona che grida verso di noi senza alcuna ragione apparente ciò scatena una lunga serie di processi (secrezione di adrenalina, blocco della digestione, liberazione del glucosio immagazzinato, etc.) al fine di far fronte a quello che in tutta probabilità è un pericolo imminente – ma ciò non significa che l’emozione è qualcosa di interiore che nasce e si sviluppa solo per ragioni scientificamente ignote. Le ragioni ci sono !

Purtroppo comunemente si è portati ad attribuire alla sfera emozionale una valenza legata ai postumi di un dualismo ormai quasi del tutto estinto e quando un ricercatore scopre un nuovo processo legato alla genesi di una sensazione interiore, è spesso accaduto di assistere ad una sorta di ostracismo contro un eretico del mondo spirituale. Pensate un po’ se si parlasse apertamente di macchine e emozioni ? Ma, dato che io non temo alcuna scomunica, lo farò lo stesso cercando di mostrare come questo apparente ostacolo dell’intelligenza artificiale altro non è che un banale modo di considerare il consueto.

Abbiamo detto che una macchina pensante deve possedere stati interni, deve cioè essere capace di mantenere una certa quantità di energia – pensatela pure come informazione – anche quando le sorgenti si sono del tutto estinte; osservate il vostro armadio per dieci secondi, chiudete gli occhi, cosa vi viene in mente ? L’armadio, naturalmente ! Ecco un semplice esempio di stato interno: l’immagine ha lasciato una traccia nei vostri processi cerebrali e, anche dopo che essa è scomparsa, voi restate mentalmente capaci di operare con essa e persino di esplorarla percettivamente in modo figurato. Adesso facciamo lo stesso ragionamento con un’emozione, il primo incontro ad esempio; non ha importanza quanto tempo è trascorso da questo evento, chiunque ha sempre vivide le immagini (in senso lato) dei suoi timori, del sudore sulla fronte, delle gioie, delle incertezze, etc. Notate che quasi tutti i termini di questa lista sono emozioni o particolari sensazioni ascrivibili ad esse. Supponete ora di chiedere ad una persona intervistata: « Ti ricordi il timore ? ». Che razza di risposta vi aspettate ?

Evidentemente quel povero malcapitato cercherà in tutti i modi di ottenere ulteriori informazioni che gli permettano di “localizzare” questo timore a cui vi riferite; se invece voi specificate subito che è vostra intenzione raccogliere informazioni sul suo primo incontro, il soggetto non avrà dubbi nel rispondervi e magari riuscirà a fornirmi perfino una descrizione dettagliata delle cause che lo portavano ad essere timoroso (lei era molto bella, lui aveva una brutta automobile, era goffo, non sapeva parlare, etc.)

Da tutto ciò cosa si deduce ? Semplicemente che le emozioni non hanno vita autonoma, esse esistono in un determinato contesto e traggono da esso ogni particolare di tipo esistenziale. Il timore non è, il timore è a causa di x e y, ovvero nel contesto generato dagli eventi generici x e y.

Come abbiamo detto poc’anzi l’emozione si sovrappone ad una configurazione mentale preesistente esattamente come un velo rosso che viene disteso su un divano bianco: il colore risultante nasce dalla somma del rosso e del bianco e sarà, in questo caso una tonalità di rosa, ma se il divano fosse stato blu notte il risultato sarebbe non più un tenero colore dalle pallide sfumature, ma piuttosto un viola scuro e otticamente potente. L’emozione filtra la realtà e certamente ne influenza l’evoluzione nel limite delle possibilità offerte dall’interazione uomo-ambiente.

Ma può accadere lo stesso per le macchine ? Io non credo che sia necessaria alcuna cautela nel dare la risposta: essa è certamente affermativa ! E la cosa più strabiliante è che basta un semplice programma per permettere la sperimentazione di quanto affermato: supponete di volere regolare la temperatura di una stanza utilizzando un sofisticato marchingegno che è molto sensibile ai colori: ad esempio se le tonalità tendono al verde esso stabilizzerà la temperatura ad un valore un po’ più alto di quello richiesto, mentre se i suoi sensori cromatici rilevano un’alta presenza di componenti spettrali vicino al rosso esso deciderà di ridurre ulteriormente la temperatura.

Adesso prendete una stanza priva di qualsiasi mobile – supponiamo che ciò implichi neutralità per il regolatore – e fissate il termostato a 20 °C, dopo un transitorio più o meno lungo la stanza sarà effettivamente climatizzata al valore desiderato. La macchina quindi sta eseguendo un compito di norma senza alcuna influenza di tipo emozionale, ma se ad tratto decideste di introdurre nel locale un grosso tavolo dalle sfumature verdognole cosa accadrebbe ? Evidentemente il sistema abbasserebbe la temperatura, diciamo di 2 °C; il suo programma di regolazione è rimasto inalterato eppure sembra quasi che si sia verificata un’anomalia di funzionamento… Se non vi scandalizzate troppo mi spingo ad una spiegazione più ardita, altrimenti vi consiglio di saltare a piè pari l’intero paragrafo !

Ciò che è accaduto può essere riassunto nel seguente modo: all’inizio lo stato interno del sistema corrisponde ad una temperatura ambientale di 20 °C e ciò può essere assimilato (metaforicamente) ad un individuo che cammina per strada liberamente con 60 pulsazioni cardiache al minuto; ad un certo punto un evento particolare ed imprevisto si presenta sulla scena: il tavolo verde per la macchina, una donna mozzafiato per l’uomo. Cosa accade ? Nella persona le pulsazioni aumenteranno rapidamente a causa della maggiore disponibilità di adrenalina ed ella avrà l’impressione (non è una vera impressione, ma piuttosto il risultato di un’informazione fornita dal senso interno) di provare una forte emozione, nella macchina, invece, quell’evento inatteso comporterà un’abbassamento del set-point di temperatura e anch’essa “potrà” vantare una sensazione anomala in quanto si ritroverà con uno stato interno (la temperatura della stanza, per i nostri scopi) differente da quello pre-memorizzato. E’ come se effettivamente ci fossero 20 °C (o 60 pulsazioni), ma per ragioni particolari la variazione di questo valore induce la consapevolezza di un evento particolarmente importante.

Se, ad esempio – permettetemi una divagazione fantascientifica – , il regolatore si “nutrisse” di elementi presi da sorgenti di colore rosso o verde, esso, attraverso l’imprevista variazione di temperatura potrebbe predisporsi per “corteggiare” un tavolo od una tenda con l’obiettivo di strappare ad essi un po’ di energia !

Allo stesso modo, ma in maniera meno ironica, l’individuo che prova la forte emozione dell’incontro si prepara (o tenta di prepararsi) ad un approccio il cui unico fino è il raggiungimento di un congresso carnale. Mi sembra più che evidente che le normali attività mentali non vengono “deviate” dall’emozioni, semmai, come già accennato, esse ne filtrano il contenuto e la forma e le adattano ad una nuova realtà incipiente.

“Much ado about nothing” scriveva Shakespeare e non c’è territorio scientifico ove la polvere sollevata è così fitta da impedire di vedere persino di fronte ai propri occhi… Adesso non vorrei che molti psicologi mi attaccassero dicendo che l’emozione gioca un ruolo funzionale importantissimo per la vita della persona, perché io non ho negato né questo fatto, né tantomeno che una buona macchina programmata in senso lato per essere intelligente potrebbe realmente avvantaggiarsi da un’approccio interattivo basato anche su questi “sbalzi informazionali”. Ciò che ho voluto enfatizzare è l’eccessiva immaterialità che viene conferita de facto a questo tipo di sensazioni che, tra l’altro, nascono non dallo sviluppo ontogenetico e filogenetico dell’uomo, ma piuttosto appartengono alla sfera più primordiale dell’encefalo. Joseph LeDoux, nel suo bellissimo libro “Il Sè sinaptico”, sottolinea proprio il ruolo svolto dall’amigdala nella decodifica delle emozioni ed in particolare della paura; in un articolo [7] apparso sulla rivista italiana Mente&Cervello, Hubertus Breuer scrive: « …fu questa la sua grande scoperta (di Ledoux n.d.GB): una pietra miliare della ricerca sulle emozioni. Aveva trovato un circuito di commutazione arcaico, grazie al quale i ratti possono percepire il mondo indipendentemente dalla loro corteccia cerebrale. “Questo sistema sensoriale”, spiega LeDoux, “risale presumibilmente ad una fase molto antica dell’evoluzione. E deve essere stato di grande aiuto ai vertebrati quando la corteccia cerebrale non era ancora sviluppata. ». L’emozione non è quindi figlia dell’evoluzione che ha portato l’uomo da uno stato di totale ignoranza ad oggi, ma piuttosto un retaggio del passato che si è conservato attraverso i millenni solo ed esclusivamente perché è in grado di bypassare più rapidamente i canali convenzionali in tutte quelle situazioni che lo richiedono. Lo stesso autore, più avanti, scrive: « Nella vita di tutti i giorni il nostro cervello riceve contemporaneamente impressioni ottiche sommarie e dettagliate. Perciò, sostiene LeDoux, probabilmente usiamo due vie parallele per valutare l’ambiente: “In modo rapido e inconscio con l’amigdala, per saggiare la situazione; in modo più lento e cosciente con la corteccia, per riconoscere i particolari”. E questa struttura potrebbe essere valida per tutti i cinque sensi: vale a dire, l’amigdala esaminerebbe tutte le percezioni sensoriali alla ricerca di segnali di pericolo. ». Questo parallelismo intrinseco nel processamento delle informazioni può e spesso viene attuato anche in sistemi artificiale privi di qualsiasi parte intelligente: si separano due cammini in modo che qualora dovesse accadere qualcosa di estremamente grave, un circuito di sicurezza potrebbe bloccare completamente il sistema. Ma allora, mi pongo di nuovo la fatidica domanda, le macchine possono avere emozioni ?

Alla luce di quanto scoperto negli ultimi anni l’emozione è basilare per la vita, ma è nel contempo generata da un meccanismo estremamente primordiale; a rigor di logica l’intelligenza artificiale ispirata alle capacità inferenziali, mnemoniche ed esplorative della mente umana non dovrebbe neppure prendere in considerazione processi tanto “obsoleti”, tuttavia proprio a causa dell’importanza rivestita dagli stessi, importanza che li ha preservato durante l’evoluzione, è bene che i moderni scienziati e progettisti li tengano bene in conto, ma senza trattarli come processi anomali, come stranezze della vita biologica fatta di cellule, proteine, molecole, DNA, etc. L’emozione è uno stato mentale peculiarmente più immediato e sconvolgente degli altri, ma rimane sempre un “semplice” stato mentale.

La mente è un programma?

Quando Paul e Patricia Churchland pubblicarono il loro famoso articolo in cui affermavano che la mente umana altro non era che un “semplice” programma per calcolatore, ciò che accadde nel mondo scientifico fu paragonabile, con il dovuto rispetto, alla presentazione da parte di Galileo del Dialogo sui Massimi Sistemi ! Immediatamente si crearono due fazioni contrapposte, la prima (quella dell’IA forte) iniziò a sostenere questa tesi, mentre la seconda, cauta, polemica e con qualche libro di logica matematica in più in biblioteca, cercò in tutti i modi, fate attenzione, non di mostrare il contrario adducendo prove di una nuova realtà, ma piuttosto giocherellando con i paradossi e con qualche strano teorema. Il discorso è molto più semplice di quanto si possa immaginare ed è doveroso riassumerlo brevemente per poter proseguire il nostro discorso: prendete un sistema formale di simboli e regole, eventualmente introducete qualche assioma (senza esagerare) e successivamente cercate di dimostrare deduttivamente tutte le conseguenze che ne possono derivare. Che risultato ne otterrete ? Filosoficamente parlando, dopo un meticoloso lavoro di convalida, voi dovreste raggiungere una posizione stabile dalla quale poter esprime qualsiasi giudizio di verità. Ad esempio voi dovreste subito dire che se A + B = C, A + B = D è vera se e solo se C = D.

Il sistema formale diventa quindi un sorta di micro-universo con i suoi pianeti, le sue stelle e tutte le leggi che ne governano il moto: ogni cosa sta al suo posto e nulla accade senza che un ragionamento elementare possa validarne la compatibilità con il sistema, ogni dubbio è bandito per legge e la certezza apodittica viene incoronata regina della ragione !

Qualcosa del genere fu tentato da Russel e Whitehead con i loro “Principia Mathematica”, esso fu un fallimento e la cosa più drammatica è che il sabotaggio avvenne quando ormai i due studiosi avevano tirato fuori migliaia di proposizioni ed erano sul punto di cantare l’inno di vittoria…

Kurt Gödel al suo interno proposizioni indecidibili: notate bene che esso non viola il principio del terzo escluso, semplicemente dice che non esiste alcuna deduzione a partire dai concetti fondamentali che permetta di raggiungere una conclusione binaria sulla vere esaustivi quando si tratta di un sistema formale. Poco tempo dopo la pubblicazione del teorema di Gödel, Alan Turing mostrò che la sua macchina universale risentiva dello stesso problema, esistevano ovvero programmi particolari su cui nessun altro programma era in grado di decidersi se essi avrebbero terminato il loro lavoro o meno; in [6] Roger Penrose discute ampiamente questo problema e mostra con un certo entusiasmo che noi, poveri esseri umani, siamo in grado di costruire un algoritmo che ciclerà all’infinito, ma, nello stesso tempo, siamo certi che nessun altro programma formale potrà mai raggiungere una soluzione in merito al problema dell’arresto.

Che cosa significa tutto ciò ? In parole povere questi due risultati mostrano che la mente umana è capace di decidere (spesso, ma non sempre) anche quando essa ha dimostrato un teorema che bandisce ogni decisione; per dirla come Penrose: « …Come ho detto in precedenza, buona parte della ragione per credere che la coscienza sia in grado di influire su giudizi di verità in un modo non algoritmico deriva dalla considerazione del teorema di Gödel. Se riusciamo a renderci conto che il ruolo della coscienza non è algoritmo nella formazione dei giudizi matematici, in cui sono un fattore importante il calcolo e la dimostrazione rigorosa, allora senza dubbio potremo convincerci che un tale ingrediente non algoritmico potrebbe essere cruciale anche per il ruolo della coscienza in situazioni più generali (non matematiche). ».

La mente è dunque un programma ? Ovvero è possibile costruire una macchina di Turing che esegua ogni operazione cosciente in modo esattamente uguale ad un essere umano ? Per quanto affermato finora è chiaro (anche se non di immediata comprensione) che la risposta tende inesorabilmente verso il negativo.

In effetti l’unico modo per chiudere per sempre la questione sarebbe quello di dimostrare l’impossibilità delle ipotesi, ma ciò non è mai stato fatto e moltissime ricerche nel campo dell’intelligenza artificiale hanno continuato ad andare avanti dando per scontato che da un giorno all’altro sarebbe venuto fuori questo tanto osannato “programma della mente”.

Mentre Penrose si affannava a cercare quel “di più” [2] che avrebbe trasformato l’indecidibile in decidibile, una sostenuta schiera di sostenitori dell’IA forte combatteva in prima linea una battaglia contro coloro (come John Searle) che condannavano non tanto l’algoritmo in sé facendo affidamento alla matematica ma piuttosto all’operazione di manipolazione formale di simboli che altro non è che proprio il tanto vituperato programma. Nel prossimo paragrafo parleremo di tutto ciò, ma adesso fermiamoci sulla questione sostenuta dall’IA forte e cerchiamo di analizzarla alla luce della multidisciplinarità necessaria.

Secondo me il problema non è tanto quello di stabilire su basi scientifiche se la mente è o meno un programma, ma piuttosto di fissare un punto d’osservazione stabile per tutti i fenomeni psicologi studiati; se infatti si sceglie la strada dello studio comportamentale è quasi inevitabile imbattersi in procedure più o meno rigorose che, a partire da un insieme di dati in ingresso, conducono il soggetto verso il raggiungimento di un obiettivo ben preciso. In quasi tutti i testi di Psicologia Cognitiva mi è spesso capitato di osservare grossi scarabocchi che altro non erano che diagrammi di flusso, ovvero il mezzo grafico più canonico utilizzato per descrivere gli algoritmi.

Tutto ciò non può che formare nel lettore l’idea che ogni sua azione materiale o mentale sia perfettamente inquadrata all’interno di uno schema particolare che viene attuato dal cervello quando se ne presenta l’occasione; anche lo stesso Searle, che come vedremo è il più acerrimo nemico dell’IA forte, ammette: « …noi siamo istanziazioni di una quantità di programmi per calcolatore e siamo capaci di pensare. ».

E’ molto importante, tuttavia, sottolineare il verbo “istanziare” che non va confuso con elencare o simili; la sua accezione è fortemente legata al concetto di algoritmo: esso è un’insieme formale di regole che, se eseguite correttamente portano ad un risultato preciso, mentre l’istanziazione è qualcosa di molto diverso, infatti non c’è più alcun agente che esegue ciecamente i compiti previsti in quanto essi emergono dal comportamento stesso. D’altronde il dibattito è venuto a galla proprio perché i Churchland affermarono senza troppe remore che la mente era un programma, non un’istanziazione di esso; in questo modo tutti gli schemi di cui sopra non verrebbero più a rappresentare le sintesi procedurali di alcuni importanti processi cognitivi, ma i processi stessi ! Anche il lettore meno informato sull’argomento si potrà facilmente rendere conto del pandemonio che queste illazioni suscitarono nel mondo accademico e della gioia sfrenata di tutti i programmatori di IA che, da quel momento, non lavoravano più su sterili listati di codice, ma piuttosto su micro-menti a pieno diritto !

A mio parere, tuttavia, il profondo effetto dovuto a questa posizione è proprio da ricercarsi nel connubio instauratosi con altre branche delle scienze cognitive, prima fra tutte la psicologia; che senso ha studiare i processi neurofisiologici del cervello ?

Questo era il motto dei sostenitori dell’IA forte, ma anche, e nessuno se la prenda, della maggior parte degli psicologi, i quali preferivano uno studio di “alto livello”, filtrato da ogni forma di elaborazione cerebrale. La vista, l’udito, il tatto, il senso dell’orientamento, ecc. venivano (e vengono tuttora) considerati a partire dai risultati (bottom-up) e, semmai successivamente, si procedeva ad un indagine più accurata delle cause reali che dovevano generarli.

L’idea di fondo era quella che se tu sentivi un suono dovevi possedere un sistema acustico appropriato, qualunque esso fosse: l’orecchio con il sistema di ossicini, un altoparlante da 1 Watt, oppure, perché no ?, un omino piccoletto che sussurrava al cervello ciò che egli doveva udire. Il calcolatore per i sostenitori dell’IA forte aveva un ruolo così marginale che furono addotti esempi persino con macchine costruire con tubi e serbatoi ! Tutto ciò non poté che accentuare il distacco esistente tra la psicologia e la fisiologia funzionale: la prima galoppava verso innumerevoli traguardi, mentre la seconda ristagnava nel grande mare delle conoscenze che da Golgi e Cajal hanno riempito i libri di testo.

Cos’è un neurone ? Che cos’è una rete neurale ? A che serve il corpo calloso, il cervelletto, l’amigdala ? Per moltissimi anni domande come queste (soprattutto l’ultima) cedettero il passo a questioni comportamentali ben più evidenti, soprattutto tenendo conto del fatto che la psicologia rivolgeva molti sforzi non solo alla comprensione, ma anche alla clinica.

La mente poteva essere quindi vista come un programma, e ciò non perché esistessero scoperte probanti, ma piuttosto perché un’intricata matassa di necessità legava le gambe ai pochi sostenitori del genuino approccio di stampo medico-anatomico. Ma che ruolo gioca il test di Turing in tutto ciò ? Come abbiamo già detto in precedenza esso è stato formulato a netto svantaggio per le macchine e per di più impone che esse tentino in tutti i modi di proclamarsi esseri umani a tutti gli effetti: insomma, si tratta di un gioco dove le peculiarità della mente umana devono inevitabilmente essere codificate in un lunghi programmi per calcolatore.

Se ciò non accadesse si finirebbe col creare semplici interfacce di colloquio come ELIZA di Weizenbaum che non possono né superare il test, né tantomeno riflettere i risvolti comportamentali di un essere umano. Io credo che allo stato attuale l’unico modo per vincere al gioco dell’imitazione sia quello di partire dall’assunto che la mente, pur non essendo un reale algoritmo per calcolatore, debba comunque essere codificata in termini di manipolazioni di simboli formali, anche se da ciò non ci si dovrebbe aspettare più di tanto.

Tuttavia, come fanno notare gli stessi Churchland: « …il tipo di scetticismo (sulla mente come programma. N.d.GB) manifestato da Searle ha numerosi precedenti nella storia della scienza. Nel Settecento il vescovo irlandese George Berkeley trovava incomprensibile che le onde di compressione dell’aria fossero, di per sé, essenziali o sufficienti per dare il suono obiettivo. Il poeta e artista inglese William Blake e il poeta e naturalista tedesco Johann Wolfgang von Goethe consideravano inconcepibile che minuscole particelle potessero, di per sé, essere essenziali o sufficienti per generare il fenomeno obiettivo della luce.

Perfino in questo secolo alcuni hanno trovato inimmaginabile che la materia inanimata, per quanto ben organizzata, potesse da sola costituire una premessa essenziale o sufficiente per la vita. E’ evidente che spesso quanto gli uomini riescono o non riescono a immaginare non ha niente a che fare con la realtà, e questo accade anche a persone molto intelligenti… ». Cosa dire in proposito ?

I Churchland, probabilmente messi con le spalle al muro da un’ondata di critiche malefiche, hanno fatto il ragionamento più logico che si potesse fare, prima ancora di qualsiasi speculazione puramente razionale; è chiaro che queste affermazioni non sono certo a suffragio della loro tesi (che resta in balia dei nemici dell’IA forte), ma certamente esse permettono di giustificare l’uso dei programmi quando si tenta di dimostrare l’intelligenza attraverso il test di Turing.

Come vedremo nel prossimo e ultimo paragrafo la risposta alla domanda sulle menti non può ritrovarsi nemmeno nel tanto osannato esempio della stanza cinese e metteremo in luce le cantonate tremende che lo stesso John Searle ha preso trattando l’IA come un mezzo di conferma di un’ipotetica teoria della mente.

Il significato e la stanza cinese

E arriviamo adesso al punto tanto agognato… la stanza cinese di Searle e il suo fallimentare tentativo di cancellare dalla faccia della Terra ogni misero sostenitore dell’IA forte ! Ebbene, per chi non lo sapesse, è doveroso premettere anche se brevemente come funziona questo esperimento [1]: « …Supponiamo che io mi trovi chiuso in una stanza con un grande foglio di carta tutto coperto di ideogrammi cinesi. Supponiamo inoltre che io non conosca il cinese (ed è proprio così), scritto o parlato, e che io non sia nemmeno sicuro di riuscire a distinguere la scrittura cinese dalla scrittura diciamo, giapponese o da sgorbi privi di significato: per me gli ideogrammi cinesi sono appunto sgorbi privi di significato.

Ora supponiamo che, dopo questo primo foglio in cinese, mi venga fornito un secondo foglio scritto nella stessa scrittura, e con esso un insieme di regole per correlare il secondo foglio col primo. Le regole sono scritte in inglese e io capisco queste regole come qualsiasi altro individuo di madrelingua inglese.

Esse mi permettono di correlare un insieme di simboli formale con un altro insieme di simboli formali; qui “formale” significa semplicemente che io posso identificare i simboli soltanto in base alla loro forma grafica. Supponiamo ancora che mi venga data una terza dose di simboli cinesi insieme con alcune istruzioni, anche queste in inglese, che mi permettono di correlare certi elementi di questo terzo foglio coi primi due, e che queste regole mi insegnino a tracciare certi simboli cinesi aventi una certa forma in risposta a certi tipi di forme assegnatomi nel terzo foglio. A mia insaputa le persone che mi forniscono tutti questi simboli chiamano il contenuto del primo foglio “scrittura”, quello del secondo “storia” e quello del terzo “domande”. Inoltre chiamano “risposte alle domande” i simboli che io do loro in risposta al contenuto del terzo foglio e chiamano “programma” l’insieme delle regole in inglese che mi hanno fornito. …Nessuno, stando solo alle mie risposte, può rendersi conto che non so neanche una parola di cinese. …Dal punto di vista esterno, cioè dal punto di vista di qualcuno che legga le mie “risposte”, le risposte alle domande in cinese e a quelle in inglese sono altrettanto buone.

Ma nel caso del cinese, a differenza dell’inglese, io do le risposte manipolando simboli formali non interpretati. Per quanto riguarda il cinese, mi comporto né più né meno che come un calcolatore: eseguo operazioni di calcolo su elementi specificati per via formale. Per quanto riguarda il cinese, dunque, io sono semplicemente un’istanziazione (ossia un’entità totalmente corrispondente al suo tipo astratto) del programma del calcolatore… ».

Cominciamo innanzi tutto col dire che questo non è un esperimento per la valutazione di una coscienza artificiale: John Searle ingabbiato nella sua stanzetta cinese è come un pesce rosso che dall’interno di una boccia di vetro crede che il suo macrocosmo si consumi in pochi centimetri cubici. Allora, solo per dovere verso la scienza, diremo che questa prova assomiglia tanto ad uno di quegli esperimenti “puri”, ossia del tutto ideali e virtuali, molto spesso chiamati in causa dalla fisica teorica e ci limiteremo a valutare quanto assurde siano le sue premesse senza nemmeno sfiorare con la mente tutte le varianti, risposte e alternative che questo dilemma ha suscitato.

Ovviamente possiamo dire che Searle ha perfettamente ragione quando afferma che la sintassi non può generare la semantica: ciò mi sembra oltre che ovvio da un punto di vista linguistico, anche estremamente razionale in quanto non esiste alcuna regola che possa regolare il processo di significazione di una frase espressa in un dato idioma.

La sintassi è quindi solo un insieme di prescrizioni che dovrebbero essere rispettate affinché possa avvenire la comunicazione tra due membri della medesima comunità culturale; per dirla come Claude Shannon, essa rappresenta il codice comune sia all’emittente che al destinatario e la sua integrità è alla base del processo di decodifica.

Non credo che, come i Churchland hanno spesso ribadito, dalla sintassi possa scaturire alcunché di straordinario, almeno finché non viene introdotta la semantica. La stanza cinese è un luogo virtuale privo di qualsiasi collegamento con i significati e quindi incapace di significare; questo è il primo punto a sfavore della tesi di Searle: chi ha mai detto che, qualora effettivamente la mente fosse un programma, esso dovrebbe limitarsi a manipolare simboli senza operare alcuna associazione con la realtà cosciente ?

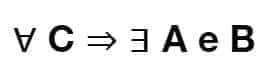

Noi stiamo dibattendo di intelligenza artificiale, non di matematica pura ! Possiamo pensare di costruire un programma che, pur manipolando simboli, operi nel contempo con gli oggetti ad essi associati e quindi acquisti coscienza degli stessi: per chiarirci le idee pensiamo ad un semplice sistema formale costituito da tre simboli { A, B, C } e introduciamo una funzione biunivoca (chiamiamola f(x)) che associa a ciascuno di essi tre immagini, ad esempio (nell’ordine) un vaso, un mucchio di terra e un fiore.

Adesso analizziamo la proposizione:

ovvero: per ogni fiore (C) deve esistere un vaso (A) pieno di terra (B). La regola scritta sopra è espressa secondo il linguaggio formale della logica, ma, in virtù delle associazioni mentali, è possibile immaginare la situazione pensando direttamente alla sovrapposizione di f(A), f(B) e f(C), o, in termini meno astratti, ad un quadretto in cui è raffigurato un vaso con un fiore; l’unica condizione a priori – che tuttavia non può che essere esperita – è la necessità di A e B affinché C possa mantenersi tale. Con questo esempio ho voluto mostrare che, seppur non conoscendo il sistema formale, è sempre possibile utilizzarlo, magari con l’aiuto di un buon interprete, basandosi esclusivamente sulla coscienza dei fatti o, per meglio dire, dei significati.

Dov’è il significato nella stanza cinese ? Per quanto riesca a sforzarmi io vedo solo manipolazioni di simboli e ciò non mi stupisce più di tanto perché questo è proprio ciò che Searle desidera…. Tuttavia, per onestà intellettuale, bisogna dire che una mente, per come la si voglia intendere, non può prescindere dalla manipolazione di significati , i quali, a loro volta, scaturiscono principalmente dall’interazione con l’ambiente esterno. Volendo costruire una macchina secondo i criteri dell’IA forte, a mio parere, non bisogna abbandonarsi ad un enorme gruppo di regole operanti su scarabocchi chiamati comunemente simboli: un tale computer sarebbe in grado di fare molte belle cose e magari anche di superare il test di Turing, ma non potrebbe mai essere definito intelligente nell’accezione del termine che noi esseri umani utilizziamo.

In pratica ciò che è accaduto è una miscomprensione da ambo le parti: i Churchland proposero una visionaria teoria della mente e, dal canto suo, John Searle rispose con un controesempio che di reale aveva forse solo la stanzetta ! L’errore più grande commesso dai primi è stato quello di attribuire al simbolo un potere causale particolare, cosa alquanto strana data l’arbitrarietà dei sistemi formali; mentre il secondo ha, non soltanto postulato l’impossibilità di avere una mente priva di semantica, ma ha anche evitato abilmente l’uso della stessa nel formulare il suo famoso esempio.

Per un italiano (o un inglese) gli ideogrammi cinesi restano sempre delle tracce più o meno graziose su un pezzo di carta, niente di più; e nessun sistema esterno che abbia come dominio e codominio le stesse potrà mai estrarre informazioni chiarificatrici sul perché quei simboli sono stati tracciati.

Per quanto ci si impegni nel valutare tutte le possibili alternative (come ad esempio la risposta sui sistemi formulata dai ricercatori di Berkeley) nessuna forza intellettuale è in grado di piegare le barriere che separano il mondo dalle rappresentazioni, ma questo Searle non l’ha detto, egli lo ha taciuto per ragioni a me ignote, ma di certo col (falso) risultato di acuire la portata della critica contro i sostenitori dell’IA forte.

Rivalutiamo adesso la domanda: “La mente è un programma ?”, lo stesso Searle risponde quando gli si chiede se un calcolatore digitale può pensare che: « …Se per “calcolatore digitale” intendiamo una qualunque cosa per cui esista un livello di descrizione al quale la si possa descrivere correttamente come un’istanziazione di un programma per calcolatore, allora la risposta è (di nuovo), ovviamente, sì, poiché noi siamo instanziazioni di una quantità di programmi per calcolatore e siamo capaci di pensare. ».

Su questo punto concordo pienamente con Searle ed evidentemente non posso che aborrire l’ipotesi che la mia mente in quanto tale sia un programma, anche perché: « …La distinzione fra il programma e la sua realizzazione nei circuiti del calcolatore sembra corrispondere alla distinzione tra il livello delle operazioni mentali e il livello delle operazioni cerebrali. E se potessimo descrivere il livello delle operazioni mentali come un programma formale, allora, a quanto parrebbe, potremmo descrivere quella che è l’essenza della mente senza ricorrere né alla psicologia introspettiva né alla neurofisiologia del cervello. Ma l’equazione “la mente sta al cervello come il programma sta allo hardware” fa acqua in parecchi punti… ».

Da ciò si evince perfettamente il significato della parola “istanziare” e, senza forzare troppo le parole, mi sembra che il passaggio da lista di istruzioni ad istanza della stessa possa avvenire solo ed esclusivamente grazie ai quei processi di significazione associativa di cui ho accennato sopra.

Tuttavia c’è un neo su cui vale la pena insistere ancora un po’: esiste una concezione molto diffusa e anche corretta che vede l’intelligenza artificiale non solo come un prodotto pseudo-tecnologico, ma piuttosto come base d’indagine per le scienze cognitive. Naturalmente vorrei precisare che qui non si sta parlando di simulazione di processi mentali, pratica ben accetta anche da Searle ed esposta molto bene in [15], ma piuttosto della costruzione di organismi che possiedano realmente le facoltà mentali che si desidera studiare.

Proprio in quest’ambito il filosofo californiano sembra proprio uscire dai gangheri: « …Lo studio della mente parte da fatti come quello che gli uomini hanno delle convinzioni mentre i termostati, i telefoni e le addizionatrici non ne hanno. …convinzioni che abbiano la possibilità di essere forti o deboli, nervose, ansiose o salde, dogmatiche, razionali o superstiziose; fedi cieche o cogitazioni esitanti; ogni sorta di convinzioni. …».

Innanzi tutto la prima affermazione è puramente illatoria in quanto non è nemmeno scientificamente corretto definire una scienza in modo negativo, non si può dire che la meteorologia non studia le reazioni atomiche, la propagazione di onde radio, etc. L’unico modo razionale di procedere è quello di porre delle basi positive e su di esse costruire mattone dopo mattone una teoria ben salda; e poi, chi ha mai detto che il mio termostato non ha convinzioni ?

Esiste forse una legge fisica che limita il concetto di “convinzione” ad un ambito privilegiato come quello degli esseri umani ? Io credo di no, ma vorrei tanto domandare al professor Searle che cosa gli passa per la testa quando pensa ad una convinzione… Egli probabilmente mi rimanderebbe alla fine del suo scritto “Menti, cervelli e programmi” per farmi rileggere ciò che io, con un po’ di furbizia, ho già citato in quest’articolo: le convinzioni devono avere attributi (rileggeteli, io non ho voglia di sprecare altre parole), cioè esse devono potersi catalogare in modo altamente astratto all’interno di schemi culturali lungi dall’essere primitivi. Insomma, per dirla con franchezza, in quelle poche parole si trova un concentrato di anti-scientificità da far rabbrividire perfino un cartomante !

Ma poi, perché il mio termostato non è convinto della temperatura ? La risposta di Searle è semplicissima e di carattere umanitario (nei confronti dei sostenitori dell’IA): altrimenti la mente sarebbe dappertutto e l’unica disciplina idonea allo studio di questo psico-tutto dovrebbe a pieno diritto essere una filosofia panpsichica.

La mia versione è leggermente diversa e in queste poche righe che ci rimangono cercherò di esporla nel modo più chiaro possibile.

Supponiamo, tanto per non cambiare argomento, di avere un termostato; esso è normalmente dotato di un sensore di temperatura che, per semplicità, consideriamo un termistore, ovvero una resistore che modifica la sua resistenza con un legge pressoché lineare con la temperatura.

Se ad esempio a 20° si ha R = 200 Ohm, a 35° magari R sarà salita a 1500 Ohm; non ha importanza l’andamento della funzione, ciò che conta è che esiste una relazione fisica ben definita che collega la temperatura ambientale con un parametro particolare – uno stato interno, per l’appunto. Tenendo presente la famosa legge di Ohm V = RI, se noi facciamo scorrere una corrente costante nel termistore (ad esempio con un transistor) la tensione che sarà presente ai suoi capi sarà a sua volta proporzionale alla temperatura e, se facciamo bene le cose ed eliminiamo le varie costanti, possiamo dire che V = T. Quando il dispositivo è accesso ci sarà sempre una V ai capi di R e quindi il sistema avrà una variabile di stato interna continua (in senso matematico) la cui dinamica nel tempo descrive l’andamento della temperatura nell’ambiente circostante.

A questo punto sorge il dilemma: secondo Searle il termostato non ne sa nulla di temperatura, secondo me invece ha una consapevolezza molto più profonda di quanto si possa immaginare. Il punto di scissione nasce dal tipo di conoscenza che viene esaminata: da un punto di vista ontologico e gnoseologico io credo che pochi al mondo sarebbero in grado di definire cosa sia la temperatura, ma sono più che certo che chiunque è in grado di stimarne il valore in qualunque momento della giornata e in qualsiasi luogo.

Se una persona sa che la temperatura è bassa, diciamo 8 °C, ella ha una convinzione in senso stretto, mentre se il termostato possiede un valore interno di 8.0002 °C, ebbene, secondo quanto afferma Searle, esso è del tutto incosciente. A me questa sembra una grossa incongruenza che può scaturire solo dal fatto che si assiomatizza un principio di esclusione (le macchine non possono avere convinzioni) senza alcun diritto. Io sono convinto quando posso verificare (con qualsiasi mezzo, perfino l’accettazione di un dogma) l’oggetto della mia convinzione e non ha alcun importanza se esistono attributi o accidenti che possono essere correlati al mio stato interno, in quanto essi vengono attribuiti da un’unità superiore che, sulla base di svariati fattori tra cui l’esperienza, può dar vita ad nuovo stato interno (uno stato dello stato) correlato con uno dei parametri esaurientemente elencati da Searle.

Anche in questo caso la minaccia della filosofia panpsichica è infondata poiché la mente non può certo essere presente solo a condizione che vi siano convinzioni e non ha senso, per evitare una catastrofe conoscitiva, deliberare che i possessori di essa debbano essere coloro trattano le informazioni in un certo modo, mentre tutti gli altri non sono altro che meri automi privi di qualsiasi scopo esistenziale.

Il mio termostato non ha una mente, ma possiede di certo un elemento che lo rende capace di interagire con l’ambiente esattamente come alcuni microorganismi possiedono ciglia e flagelli che usano per deambulare e fagocitare il loro cibo.

Ma allora esiste un confine tra un insieme di stati interni ed una mente ? A meno di non voler scomodare Cartesio con la sua res cogitans, io credo che nell’evoluzione non siano verificati “strappi” così violenti da portare una scimmia o un criceto a divenire uomini dotati di mente; io voglio supporre che in questo caso il numero sia l’elemento, se non chiave, sicuramente il preponderante nella filogenesi della mente: oggi un cervello di homo sapiens sapiens possiede circa 150 miliardi di unità attive (i neuroni) e ciascuna di esse dialoga attraverso i neurotrasmettitori e i neuromodulatori anche con ventimila altre cellule, sono mai state realizzate macchine di queste dimensioni ?

La risposta è no ! E non ha alcun senso quanto afferma Massimo Piattelli Palmarini in [4] nel momento in cui dice che il connessionismo ha portato moltissimi insuccessi quando gli esperimenti da lui citati facevano uso di computer che simulavano tutt’al più qualche centinaia di neuroni artificiali…

Io ho spesso l’impressione che si voglia dimostrare la forza di Mister Universo facendolo battere con un bimbo che muove appena i primi passi e al primo disumano KO una folla inferocita salta in piedi gridando che aveva ragione. Questa non vuole essere un’apologia al connessionismo (anche se di fatto lo è), ma come ho detto in precedenza, l’approccio scientifico che parte astraendo – come fa ad esempio la linguistica – difficilmente riuscirà a condurci a risultati reali, cioè corroborati da prove sperimentali; e non mi importa nulla che qualcuno venga a raccontarmi favole che parlano di grammatiche generali o triangoli semiotici se prima non mi si spiega come mai un bambino di poco più di 18 mesi non solo riesce a parlare, ma è in grado di comprendere e, tanto per far esultare John Searle, avere delle convinzioni. E’ mai esistito un linguista che ha studiato le aree di Broca e di Wernicke ? Eppure le persone affette da afasie di qualunque tipo presentano sempre lesioni in quelle zone del cervello…

Io credo che sia molto meglio studiare la mente utilizzando macchine programmate nel modo più opportuno (una rete neurale artificiale è in fondo anch’essa un programma) senza temere che qualche folle scienziato possa vanificare i nostri sforzi chiudendoci all’interno di una stanza cinese e senza scoraggiarci di fronte alla potenza esponenziale che i cervelli reali presentano. Vorrei chiudere parafrasando il titolo di un bellissimo libro [22] del Premio Nobel Rita Levi Montalcini: « Una stella non costituisce una galassia, ma una galassia è costituita da stelle ! ».

Riferimenti bibliografici

-

- [1] Hofstadter D., Dennet. D., L’io della Mente, Adelphi

- [2] Searle J., Il Mistero della Coscienza, Raffaello Cortina

- [3] Von Neumann J. Et alt., La Filosofia degli Automi, Boringhieri

- [4] Piattelli-Palmarini M., I Linguaggi della Scienza, Mondadori

- [5] Davis M., Il Calcolatore Universale, Adelphi

- [6] Penrose R., La Mente Nuova dell’Imperatore, SuperBur

- [7] Breuer H., Le Radici della Paura, Mente&Cervello n.8 – Anno II

- [8] Dennet. D., La Mente e le Menti, SuperBur

- [9] Pinker S., Come funziona la mente ?, Mondadori

- [10] Aleksander I., Come si costruisce una mente, Einaudi

- [11] Bernstein J., Uomini e Macchine Intelligenti, Adelphi

- [12] Eco U., Kant e l’ornitorinco, Bombiani

- [13] Minsky M., La Società della Mente, Adelphi

- [14] Brescia M., Cervelli Artificiali, CUEN

- [15] Parisi D., Simulazioni, Il Mulino

Sul connessionismo sono disponibili vari testi in lingua italiana, tra i quali:

-

- [16] Floreano D., Mattiussi C., Manuale sulle Reti Neurali, Il Mulino

- [17] Cammarata S., Reti Neuronali, Etas Libri

- [18] Parisi D., Intervista sulle Reti Neurali, Il Mulino

- [19] Parisi D., Mente. I nuovi modelli di vita artificiale, Il Mulino

Sulla neurofisiologia del cervello e della mente e sul cognitivismo:

-

- [20] LeDoux J., Il Sè sinaptico, Raffaello Cortina

- [21] Oliverio A., Prima Lezione di Neuroscienze, Laterza

- [22] Oliverio A., Biologia e Filosofia della Mente, Laterza

- [23] Montalcini R. L., La Galassia Mente, Baldini&Castoldi

- [24] Boncinelli E., Il Cervello, la mente e l’anima, Mondadori

- [25] De Bono E., Il Meccanismo della Mente, SuperBur

- [26] Bassetti C. Et Alt., Neurofisiologia della mente e della coscienza, Longo

- [27] Legrenzi P., Prima Lezione di Scienze Cognitive, Laterza

- [28] Neisser U., Conoscenza e Realtà, Il Mulino

Il saggio è anche presente nel volume “Saggi sull’Intelligenza Artificiale e la Filosofia della Mente“.

Foto di David Matos