Premessa

Un simile approccio al problema porta certamente verso una concezione dell’attività mentale che è del tutto svincolata dai limiti della materia inerte: l’uomo, pur essendo fatto di atomi esattamente come una roccia, è “costretto” a possedere una sorta di vis viva che trasmuta la sua natura oggettivamente materiale in una omologa definibile solo in termini metafisici.

Tutto ciò ha portato negli ultimi vent’anni ad un acceso dibattito tra coloro che sono del parere che è ontologicamente necessaria una distinzione tra mente e cervello e chi, come me, sostiene che ciò che noi ci ostiniamo a chiamare mente non è altro che il risultato dell’attività, reale e fisicamente analizzabile, del sistema nervoso centrale.

Grazie alle moderne tecniche di brain imaging come la PET o la risonanza magnetica funzionale è stato possibile provare sperimentalmente che determinate aree del cervello si attivano solo quando il soggetto in esame è sottoposto a particolari test; ad esempio, se si chiede di eseguire un calcolo numerico non troppo banale si evidenzia una spiccata attività bioelettrica nell’emisfero sinistro del cervello, mentre se la prova comporta la lettura mentale di un testo si vede come l’area di Wernicke, responsabile della decodificazione semantica, entri in azione, permettendo all’individuo di comprendere ciò che sta leggendo.

Naturalmente è assurdo pensare che si possa effettuare una localizzazione esatta di ogni funzione cerebrale poiché, come avremo modo di vedere, la struttura stessa del cervello è tale da consentire una fusione di flussi informativi provenienti da sorgenti diverse.

E’ proprio grazie a tale peculiarità che noi, ogni giorno, possiamo affrontare attività che scomposte in sotto-problemi risulterebbero proibitive anche per il più potente supercomputer. Come fa notare Alberto Oliverio, nel problema della lettura è necessario essere capaci di decodificare circa 40 caratteri al secondo senza alcun tipo di vincolo sulle forme e sulle caratteristiche degli stessi; se io avessi deciso di scrivere questo articolo utilizzando un font particolarmente elaborato (al limite basti pensare ai manoscritti) il mio cervello non avrebbe comunque avuto particolari difficoltà a guidare le mie dita sui tasti corretti e, rileggendo quanto scritto, io avrei lo stesso compreso il significato di ogni frase.

Un cervello “statico”, cioè fortemente localizzante, si troverebbe in estrema difficoltà ogniqualvolta si dovessero presentare alternative – funzionalmente e strutturalmente compatibili – alle strutture pre-immagazzinate; per tentare di comprendere come ciò possa avvenire dobbiamo necessariamente andare indietro nel tempo e interpellare il grandissimo filosofo Immanuel Kant: fu proprio lui, infatti, il primo ricercatore a domandarsi come mai la rielaborazione mentale di un concetto fosse quasi del tutto indipendente dalla particolare esperienza che ci ha precedentemente condotti ad esso. La prima volta che lessi la Critica della Ragion Pura rimasi fortemente turbato dall’acume dimostrato da Kant quando egli spiegava, senza fare riferimento alla posteriore psicologia cognitiva, il perché, ad esempio, la mia idea di “casa” fosse svincolata dall’edificio in cui abito o da quello che osservo guardando fuori dalla mia finestra.

La sua indagine partì dal presupposto che il pensiero di un oggetto non si forma a partire da una “catalogazione” di percezioni, ma piuttosto da una sintesi di un molteplice che scaturisce da una serie di informazioni in ingresso: la “casa” – intesa come concetto/oggetto – viene scomposta nelle sue parti peculiari e, una volta che l’idea ad essa collegata è divenuta sufficientemente stabile, il cervello ri-utilizza questi dati per poter “costruire” una casa basandosi sulle esperienze correnti o, anche solo sulla fantasia.

Naturalmente Kant non possedeva i mezzi di indagine necessari per potere, seguendo gli insegnamenti di Galileo, confermare sperimentalmente le sue ipotesi e di conseguenza si lasciò guidare solo dall’intelletto; oggi invece la situazione è stata chiarita (non del tutto, ma abbastanza per poterci scrivere sopra un articoletto!) e ad essa è stato dato il nome di “capacità di generalizzazione”. Tutto il resto dello scritto sarà dedicato a questa caratteristica della mente, per cui chiedo al lettore di avere un minimo di pazienza affinché io possa tornare momentaneamente alla domanda che fa da incipit all’articolo “Quanto è naturale l’intelligenza artificiale?” per chiarire alcuni punti essenziali.

Se si chiedesse ad una persona se la sua intelligenza è naturale è ovvio che la risposta sarebbe certamente affermativa, ma se si chiedesse che cosa essa intenda per “naturale” si potrebbero collezionare così tante spiegazioni da poter compilare una nuova enciclopedia britannica… Ognuno di noi è convinto di essere un membro della natura, intendendo con ciò che il corpo e la mente si sono formati a partire da processi che non possono in alcun modo essere definiti artificiali. Questo è vero, tuttavia a noi interessa capire se può esistere una qualche distinzione tra un uomo e un’ipotetica macchina pensante: quali parametri bisogna prendere in considerazione? E, soprattutto, a quali test è necessario sottoporre entrambe le parti?

Un primo approccio potrebbe essere quello di chiedere alla macchina se essa è naturale (ciò si rifà al famoso test di Turing), ma che valore potrebbe avere questa risposta? Un eventuale “sì” o il suo contrario non ci illuminerebbero più di tanto; è ovvio che un computer è costruito dall’uomo, ma è altrettanto scontato che gli elettroni, i protoni e i neutroni che lo compongono sono uguali sia all’interno del suo microprocessore, sia nel cervello, nel cuore e nel fegato del soggetto umano: entrambi sono “costruiti” a partire dai medesimi elementi, ma, mentre la macchina è fredda e inespressiva, la persona manifesta caratteristiche che noi definiremmo “emozionali”.

Ci si potrebbe allora chiedere se siano proprio le emozioni a fare la differenza, ma, pur rispettando coloro che pensano che esse siano una sorta di “ispirazione divina”, è giusto precisare che ciò che noi chiamiamo paura, ansia o felicità è traducibile in tutta una serie di percezioni-elaborazioni cerebrali-auto condizionamenti dovuti ai neurotrasmettitori prodotti dai neuroni e da alcuni ormoni secreti dalle ghiandole surrenali. In altre parole, l’emozione è uno stato interno che scaturisce a partire da una causa qualunque, ma che si sviluppa seguendo una sorta di copione che il nostro organismo conosce estremamente bene. (Se non fosse così la vista di un grosso serpente potrebbe attivare meccanismi selettivi che “ripetano dall’interno” la frase “Niente panico!”, ma purtroppo il controllo automatico delle reazioni – e ciò vale anche per le macchine – è quasi sempre preventivo e difficilmente modificabile dallo stesso organismo).

Scartando, quindi, anche l’ipotesi dell’emozione non resta che rifarsi alle capacità intellettive pure, vale a dire alla logica, al pensiero astratto e, in ultima analisi, anche alle capacità artistiche. Agli albori dell’intelligenza artificiale, grandi pioneri come Marvin Minsky proposero quella che per molti anni a seguire fu la “metodologia” da adottare per affrontare problemi di particolare complessità; in particolare la loro idea si basava sul presupposto che l’aggettivo “artificiale” fosse riferito non tanto all’intelligenza della macchina, ma piuttosto al fatto che un bravo programmatore riuscisse a scrivere algoritmi innovativi e capaci di far fronte a situazioni computazionalmente molto pesanti.

In pratica, seguendo questo filone, la risposta alla nostra domanda iniziale non può che essere: “L’intelligenza artificiale è naturale tanto quanto lo è un computer”, con la differenza che, mentre l’uomo è capace di astrarre ma non di calcolare velocemente, il calcoltore, opportunamente predisposto dall’operatore, è virtualmente in grado di assolvere ad entrambi i compiti. Il problema principale, tuttavia, nasce proprio dal fatto che senza l’ausilio dell’esperto umano non è praticamente possibile effettuare quella transizione di intelligenza che può migliorare il comportamento delle macchine automatiche.

Fortunatamente la ricerca si è spinta oltre il vicinissimo confine tracciato dai padri dell’intelligenza artificiale detta ormai “classica” e la cosa più stupefacente è stata non tanto la variazione di strategia, ma piuttosto l’idea che un calcolatore può divenire più intelligente solo se imita operazionalmente e strutturalmente gli organi animali preposti a svolgere tutte le svariate funzioni di controllo ed elaborazione. In parole povere, a partire dai risultati della neurofisiologia, si è pensato di implementare particolari strutture (le reti neurali) che avessero un funzionamento analogo a quello delle omologhe naturali; in questo modo – che noi non descriveremo per mancanza di spazio – fu immediato constatare che il ruolo del programmatore non era più centrale, ma andava assumendo una posizione sempre più marginale per lasciare spazio ad un’evoluzione interna semi-autonoma guidata solo dagli obiettivi che si desiderava raggiungere.

Ad esempio, con una rete di 20 neuroni, è possibile far sì che essa apprenda (apprendimento inteso come modificazione di alcuni parametri caratteristici) a riconoscere le lettere dell’alfabeto e sia in grado di riconoscere con estrema facilità un carattere distorto.

Ormai molti software per personal computer si basano su questo approccio, basti pensare ai cosiddetti OCR, ovvero a quei programmi che sono in grado di convertire un’immagine contenente del testo in un documento elettronico, oppure ai sofisticati strumenti utilizzati dalla polizia per confrontare un volto sospetto con quelli contenuti nella loro banca dati; questi naturalmente sono solo banali esempi, ma in realtà l’intelligenza artificiale basata sul connessionismo è ormai così diffusa da essere un requisito essenziale per ogni programmatore di sistemi intelligenti che si rispetti.

E’ chiaro che adesso la risposta alla domanda inizia lentamente a volgere verso un’affermazione positiva, ma ancora non è chiaro perché un semplice cambiamento di rotta abbia determinato una rivoluzione la cui portata è comprensibile solo agli scrittori di fantascienza, ma di ciò parleremo ampiamente nel prossimo paragrafo.

La capacità di generalizzare e astrarre

Credo che qualunque persona non abbia alcuna esitazione nel dire che, qualora venga suffragata l’ipotesi anti-dualistica della mente, sia il cervello – con la sua attività – la vera causa dell’intelligenza e di certo verrebbe negato il contrario; adesso se noi applichiamo il nesso causale al nostro problema la domanda da porsi è: quale linea guida dobbiamo seguire per pervenire ad un risultato concreto nel campo dell’intelligenza artificiale? Se ci affidassimo esclusivamente alle teorie classiche evidentemente il percorso sarebbe dettato dalla progressione: effetto → causa, infatti, dopo aver constatato che un buon programmatore può “insegnare” ad una macchina ad eseguire compiti difficili, l’obiettivo principale dovrebbe essere solo quello di fissare l’effetto desiderato per cercare di conseguirlo con una qualsiasi causa (programma).

Ma tale metodologia ha come effetto collaterale proprio quello di allontanarci dalla natura per farci tendere ad un risultato che non scaturisce dai medesimi effetti che si verificano in un cervello animale. Al contrario, il connessionismo procede secondo la relazione inversa: causa → effetto, cioè parte dall’osservazione del funzionamento bioelettrico dei neuroni che compongono il sistema nervoso centrale degli organismi viventi e procede con un meccanismo detto “ingegneria inversa”, ovvero cercando, tramite la simulazione e l’esperimento sul campo, di rintracciare le cause prime che generano tutti gli effetti dell’intelligenza.

E Michelangelo soleva ripetere che egli vedeva all’interno di ogni blocco di marmo una statua e il suo ruolo era solo quello di asportare le parti in eccesso! Questa frase può certamente essere considerata il sottotitolo all’emblema dell’intelligenza artificiale moderna con la sola differenza che, mentre lo scultore poteva fare uso della sua smisurata fantasia, lo scienziato deve attenersi alle osservazioni della realtà; in ogni caso, credetemi, fino ad un secolo fa o poco più, tra un blocco di travertino e il cervello non c’era, secondo il punto di vista della maggioranza della gente, quasi nessuna differenza! Solo intorno al 1960 si è cominciato a comprendere che l’unico modo di sgrovigliare la matassa era quello di cercare di riprodurre le strutture nervose di base e osservarne le proprietà emergenti, l’arrogante tentativo di forzare la natura con algoritmi sempre più sofisticati ha quindi ceduto il passo ad una più cauta analisi dei dati di fatto seguita da un’accurata sperimentazione. Ma quali sono le proprietà emergenti a cui abbiamo accennato?

Se volete pensate metaforicamente: la Pietà o il David sono proprietà emergenti all’interno del contesto blocco di marmo-attività di Michelangelo; allo stesso modo è possibile vedere che una rete neurale artificiale “svela” i suoi segreti non tanto nella fase di progettazione, cioè quando si decide di realizzarla tramite un programma al calcolatore, ma piuttosto durante il suo funzionamento. E’ come se un velo venisse lentamente rimosso da un quadro solo quando esistono osservatori che gli dedicano attenzione, altrimenti la tela rimane occultata e, tutt’al più, se ne può conoscere l’esistenza – ovvero l’effetto che la sua presenza produce all’interno di un museo – senza però essere in grado né di studiarla, né tantomeno di replicarla.

Ora non vorrei che venisse associata all’immagine del ricercatore di neuroingegneria quella del falsario artistico, non tanto perché disprezzi l’attività di quest’ultimo, ma perché l’obiettivo dell’intelligenza artificiale non è quello di produrre “cloni”, ma semmai quello di costruire macchine che riescano ad esprimere le loro potenzialità allo stesso modo della maggior parte degli esseri viventi di ordine superiore. In altre parole, questa disciplina deve prendere l’ispirazione dalla natura, ma non può pensare di esprimere i suoi risultati secondo gli stessi canoni poichè ciò oltretutto non sarebbe in alcun modo conveniente.

Tuttavia a questo punto sembra quasi che la domanda iniziale trovi una risposta negativa per quanto affermato finora: non è così. L’errore potrebbe sorgere solo se si intendesse il soggetto dell’interrogativo (l’intelligenza artificiale) legato al predicato nominale (è naturale) da una relazione di contenimento; in tal senso la logica suggerirebbe immediatamente che esiste una contraddizione netta ed è giusto eliminarla.

Ma se si analizzano le proprietà dei sistemi artificiali e quelle dei corrispondenti naturali, allora tutto cambia perché la relazione diviene una “semplice” analogia. Mi spiego meglio: l’approccio connessionista è naturale non perché utilizza cellule viventi allo stesso modo della biologia, ma perché ri-implementa le strutture organiche (cercando di essere quanto più fedele possibile all’originale) con mezzi artificiali e si attiene al loro funzionamento senza forzarne in alcun modo la dinamica.

D’altronde non ci sarebbe altro modo per osservare le proprietà emergenti che, all’interno del contesto classico, diverrebbero pre-condizionate e pre-codificate; un esempio molto importante è rappresentato dalle cosiddette SOM – Self Organizing Maps – ovvero da particolari reti neurali auto-organizzanti che sono in grado di immagazzinare informazioni in modo quasi autonomo, qualora si pensasse di fare lo stesso seguendo le strategie classiche si dovrebbe scrivere un programma in grado di collocare ogni singolo dato in una certa posizione e tutto il processo sarebbe praticamente noto a priori.

Con le SOM, al contrario, l’utente/programmatore non conosce quali locazioni di memoria (intese in senso lato) verranno utilizzate in quanto è la stessa rete a sceglierle secondo un principio di tipo associativo; ad esempio due volti con fisionomia molto simile verranno collocati in posti relativamente vicini, in questa maniera quando si effettuerà il recupero delle informazioni non si deve procedere come se ci fosse una sorta di schedulazione, ma piuttosto fornendo alla rete gli elementi peculiari da ricercare lasciando che essa si attivi maggiormente proprio in corrispondenza di quei dati che hanno una somiglianza più spiccata.

Penso che questo esempio abbia chiarito la differenza tra un approccio “innaturale” ed uno “naturale” e spero che il lettore si convinca che il territorio della neuroingegneria è lungi dall’essere piano e ben segnalato, ma che esistono dei riferimenti – la nostra stessa mente e le sue proprietà – che possono lentamente guidare la scienza sia verso la comprensione psicologica dell’uomo, sia verso l’acquisizione di capacità progettuali in grado di permettere la realizzazione di macchine sempre più vicine al modus operandi comportamentale degli esseri viventi.

Ma torniamo alla capacità di generalizzazione a cui abbiamo accennato nel primo paragrafo: l’esempio delle SOM dovrebbe già in parte aver chiarito che una struttura statica può fornire una quantità di informazione pari al massimo a quella pre-immagazzinata, al contrario una rete neurale addestrata con un insieme di dati limitato può produrre uscite (vale a dire risultati) in numero teoricamente infinito.

Pensiamo ad un’alfabeto di 21 simboli scritti in caratteri Times New Roman e associamo a ciascuna immagine della lettera un simbolo d’uscita (ad esempio un numero), ad apprendimento ultimato scegliamo una qualsiasi lettera con un carattere diverso come Arial o Helvetica, oppure deformiamo l’originale in modo casuale; sottoponendo in ingresso questo campione, a meno che l’immagine sia del tutto irriconoscibile – ciò equivale ad una perdita totale di informazione –, otterremo in uscita il numero corrispondente alla lettera corretta.

La rete ha generalizzato il campione originale “generando” una dispersione di possibili alternative ad esso che permette il riconoscimento di forme simili; notate che la parola “simile” non ha un significato matematico ben preciso! Un algoritmo classico può effettuare confronti ed eventualmente valutare la correlazione esistente tra l’immagine fornita e quelle immagazzinate, ma tale processo porta ad un insieme di grandezze puntuali che rappresentano il livello di somiglianza, ebbene, non esiste alcuna garanzia che due immagini completamente diverse portino a correlazioni diverse. Anzi, può accadere proprio che, ad esempio, una T e F, se confrontate con una R, forniscano un valore che è, se non proprio identico, molto prossimo e quindi facilmente alterabile dalla precisione finita dei calcolatori.

E’ evidente quindi che il principio di base di una rete neurale permette di aggirare questo ostacolo e, a patto che il progetto sia ben strutturato, è possibile affermare che con un numero di operazioni estremamente limitato si possa pervenire ad un risultato molto migliore di qualsiasi altra soluzione adottabile.

A questo punto è bene ricordare che l’obiettivo della ricerca è avvicinarsi alla natura, non superarla: anche una rete perfettamente addestrata può commettere errori, ma ciò non deve stupire più di tanto perché la generalizzazione è comunque limitata anche negli esseri umani; inoltre molti risultati sorprendenti sono stati raggiunti utilizzando poche decine di neuroni interconnessi, mentre, il cervello di una persona presenta circa 150 miliardi di neuroni e ciascuno di essi può avere anche 20000 interconnessioni (le cellule di Purkinje del cervelletto possono averne anche 200000!).

Finora non sono state mai implementate reti neurali artificiali di questa mole per il semplice motivo che la memoria e la potenza richiesta sono praticamente proibitive, ma in un prossimo futuro, grazie al trend in discesa del rapporto prezzo/prestazione dell’hardware, sarà possibile fare esperimenti sempre più complessi. Già oggi ricercatori come Igor Aleksander dell’Imperial College di Londra hanno messo a punto dispositivi intelligenti estremamente versatili e capaci di generalizzare e astrarre in modo alquanto promettente e i computers utilizzati rientravano sempre nella fascia delle workstations a medio/basso costo.

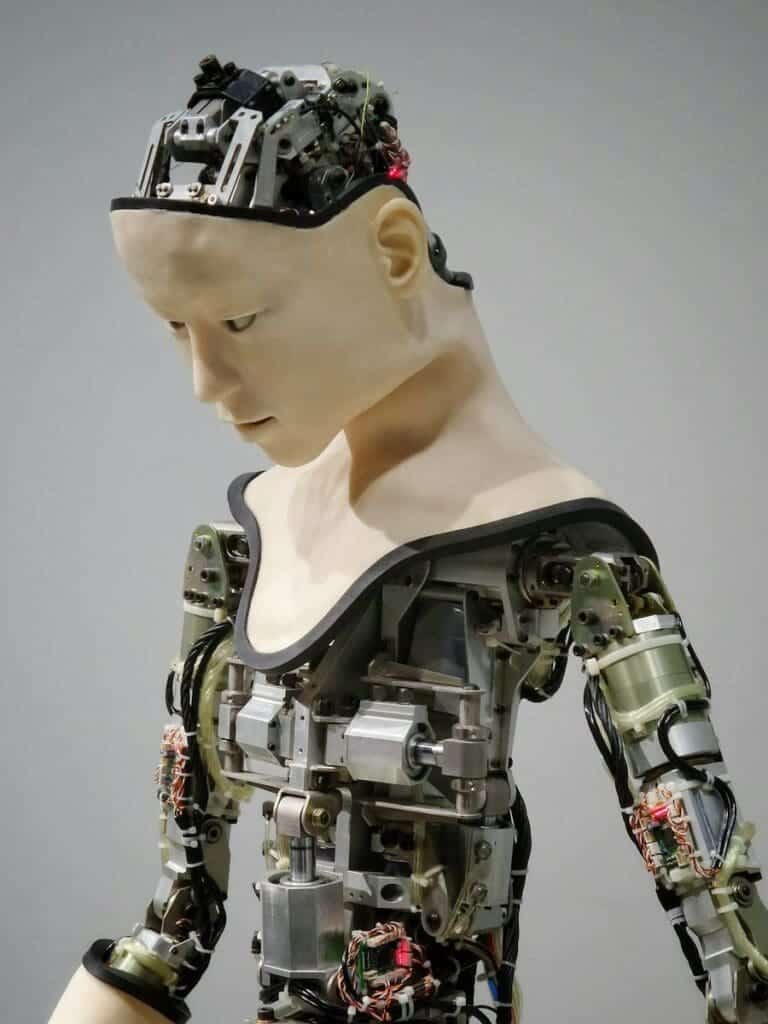

Ma quale obiettivo si può raggiunge, oltre alla generalizzazione pura, addestrando una rete neurale? Il campo dove è possibile fare esperimenti particolarmente interessanti è sicuramente quello della robotica: i robot antropomorfi, ad esempio, possono muoversi all’interno di un ambiente complesso e non strutturato e, grazie alla possibilità di possedere stati interni (pensate alla sensazione provata mangiando una mela: bene essa è lo stato interno provocato dall’input sensoriale gustativo associato alla mela), essi sono in grado di rappresentarsi lo scenario in cui si muovono e gli elementi con cui interagiscono.

In pratica una simile macchina si può comportare come un uomo primitivo che esplora cautamente il suo macrocosmo naturale e impara ad identificare gli oggetti che lo compongono; lentamente, nel cervello dell’uomo primordiale/robot, si iniziano a formare associazioni attraverso i collegamenti tra i diversi neuroni, le quali, come accade nei bambini, subiscono successivamente un processo di “potatura” che ha come scopo quello di eliminare le ridondanze e specializzare le singole aree.

Quando abbiamo parlato delle SOM abbiamo visto che esse si organizzano in modo da immagazzinare informazioni, è chiaro che dopo un certo lasso di tempo durante il quale c’è stato un flusso di dati in ingresso la rete inizia a saturare, cioè non è più capace di specializzare le sue aree per permettere il recupero corretto dei dati.

Questo processo accade anche negli esseri umani e l’unico modo di prevenirlo è quello di filtrare le informazioni percettive attraverso una serie di stadi che hanno come compito quello di selezionare solo i contenuti fondamentali ed eliminare tutto ciò che non è necessario.

Un sistema artificiale può funzionare in modo pressoché identico: basta gestire una memoria a breve termine – pensate alla RAM di un computer – che riceve i flussi sensoriali e una memoria a lungo termine (più ampia della prima ma sempre limitata) dove vengono collocate le informazioni fondamentali.

La transizione dalla prima alla seconda è regolata da un processo che diventa sempre più selettivo man mano che il robot analizza e impara a conoscere l’ambiente e gli agenti in esso presenti: all’inizio è essenziale che quasi tutte le informazioni passino nella MLT, garantendo in questo modo una solida base di partenza per l’apprendimento, ma dopo un certo tempo, che nell’uomo termina nei primi anni dell’infanzia, questo processo deve necessariamente ridursi sia per evitare il sovraffollamento della MLT, ma anche e soprattutto per lasciare spazio alla capacità di generalizzazione.

Infatti quest’ultima è fortemente subordinata ai “gradi di libertà” che possiede una rete: se si utilizzano troppi neuroni – o troppe connessioni sinaptiche tra di essi – si rischia un apprendimento di tipo mnemonico ma una scarsa attitudine a cogliere le somiglianze, mentre se si esegue una continua potatura adattativa si può riuscire a mantenere la rete in condizioni sia di ricordare che di astrarre.

Conclusioni

Quanto è naturale l’intelligenza artificiale? Molto, poco o nulla… Tutto dipende dalla strategia che si intende adottare e, purtroppo, anche dai preconcetti che hanno spesso offuscato la vista degli scienziati: un buon programma è in grado di far fronte a svariati problemi in modo ottimale, ma esso è chiuso e limitato: non ci si può aspettare nulla oltre gli obiettivi che sono stati considerati in fase di progettazione.

Un approccio connessionista, congiuntamente ai risultati forniti dalle scienze cognitive, può oltrepassare il limite dell’idea iniziale e “sbordare” in un territorio completamente inesplorato, esattamente come accade nei bambini che, da esseri del tutto immaturi, divengono lentamente persone sempre più formate sia fisicamente (e ciò è dettato dalle caratteristiche stesse dell’ambiente in cui si trovano a vivere) che psicologicamente.

La maturità rappresenta il culmine dei processi adattativi cerebrali e può essere facilmente caratterizzata da tutte le conquiste della mente individuale: il coordinamento motorio, il linguaggio, la capacità di leggere e scrivere, le abilità logico-matematiche, ecc.

Affinché un sistema artificiale possa seguire lo stesso iter di sviluppo è necessario che esso possieda le strutture di base fondamentali, ma nel contempo è importante che l’agente, o il robot, possa interfacciarsi con un ambiente variegato che gli fornisca quanti più stimoli è possibile; in altre parole ci si deve rendere conto che in questo settore la ricerca deve obbligatoriamente essere molto speculativa; se si mira a produrre software intelligenti ma con una scarso insieme di possibilità d’azione il risultato non può che mantenersi negli standard odierni o migliorare solo leggermente, al contrario se si investe nel settore delle applicazioni svincolate dal contesto (come i robot antropomorfi o gli agenti virtuali con capacità semantico-sintattiche) è molto più probabile che si pervenga in breve tempo ad un lunga serie di conquiste che, nella migliore delle ipotesi, può culminare proprio nella realizzazione di macchine dotate di un’intelligenza naturale.

Per concludere questo articolo desidero ricordare che proprio Galileo Galilei, padre della scienza moderna, fu il primo a far notare che se si desidera studiare la natura bisogna prima di tutto rispettarla: le teorie sono sempre bene accette ma lo scienziato deve comunque affidarsi all’esperimento sia come mezzo di convalida delle stesse, sia per trovare nuovi spunti di ricerca. L’intelligenza artificiale è una scienza solo ed esclusivamente quando parte dalla realtà di base (l’intelligenza degli esseri viventi), la studia e, solo dopo averne compreso almeno qualche aspetto, tenta di modellarla con i mezzi forniti dalla tecnologia moderna; d’altronde che senso avrebbe parlare di qualcosa che deve essere artificiale ma che nello stesso tempo rispecchia una realtà naturale senza fare ricorso proprio alle sorgenti di cui l’uomo può disporre?

L’ingegneria del software può essere d’aiuto, ma, a mio parere, l’unica vera strada percorribile è quella tracciata dalle neuroscienze e dalla psicologia cognitiva che, insieme con i risultati della matematica e della fisica, possono veramente aprire le porte ad un nuovo ed affascinante millennio di conquiste!

Riferimenti bibliografici

-

- Oliverio A., “Prima Lezione di Neuroscienze”, Editori Laterza

- Floreano D., Mattiussi C., “Manuale sulle Reti Neurali”, Edizioni il Mulino

- Parisi D., “Mente: i nuovi modelli di vita artificiale”, Edizioni il Mulino

- Legrenzi P., “Prima Lezione di Scienze Cognitive”, Editori Laterza

- Aleksander I., “Come si costruisce una mente”, Einaudi

- Neisser U., “Conoscenza e realtà”, Edizioni il Mulino

- Penrose R., “La mente nuova dell’imperatore”, Edizioni SuperBur

Articolo originariamente pubblicato su “La Rivista del Galilei”, Edizioni Bruno Mondadori.

Il saggio è anche presente nel volume “Saggi sull’Intelligenza Artificiale e la Filosofia della Mente“.

Se ti piace il saggio, puoi sempre fare una donazione per supportare la mia attività. Basta un caffè!